1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 | 29 | 30 | 31 | 32 | 33 | 34 | 35 | 36 | 37 | 38 | 39 | 40 | 41 | 42 | 43 | 44 | 45 | 46 | 47 | 48 | 49 | 50 | 51 | 52 | 53 | 54 | 55 | 56 | 57 | 58 | 59 | 60 | 61 | 62 | 63 | 64 | 65 | 66 | 67 | 68 | 69 | 70 | 71 | 72 | 73 | 74 | 75 | 76 | 77 | 78 | 79 | 80 | 81 | 82 | 83 | 84 | 85 | 86 | 87 | 88 | 89 | 90 | 91 | 92 | 93 | 94 | 95 | 96 | 97 | 98 | 99 | 100 | 101 | 102 | 103 | 104 | 105 | 106 | 107 | 108 | 109 | 110 | 111 | 112 | 113 | 114 | 115 | 116 | 117 | 118 | 119 | 120 | 121 | 122 | 123 | 124 | 125 | 126 | 127 | 128 | 129 | 130 | 131 | 132 | 133 | 134 | 135 | 136 | 137 | 138 | 139 | 140 | 141 | 142 | 143 | 144 | 145 | 146 | 147 | 148 | 149 | 150 | 151 | 152 | 153 | 154 | 155 | 156 | 157 | 158 | 159 | 160 | 161 | 162 | 163 | 164 | 165 | 166 | 167 | 168 | 169 | 170 | 171 | 172 | 173 | 174 | 175 | 176 | 177 | 178 | 179 | 180 | 181 | 182 | 183 | 184 | 185 | 186 | 187 | 188 | 189 | 190 | 191 | 192

Vous aimez ce site?

Articles

-

Autres

-

Histoire.

-

News

-

Tech

-

Ultra

- 3i atlas

- Anomalie mer baltique

- Apollo 20: mythe ou réalité?

- Base lunaire

- Divulgation cosmique

- Essai sur le classement des civilisations

- La vérité est en train d'exploser sur Internet

- La vie sur MARS

- Lac Baïkal

- Le chevalier noir.

- Le mystérieux objet bleu sur Mercure…

- Michael E. Salla

- Momies de Nazca

- Mort de Max Spiers

- Nazca: piste d'atterrissage?

- Nettoyage spatial

- Osirunet

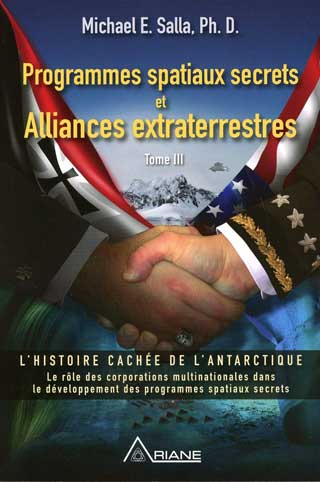

- Oumuamua

- Ovni sur la lune

- OVNIS et EDF.....

- Ovnis Saturne

- Photos de la lune.

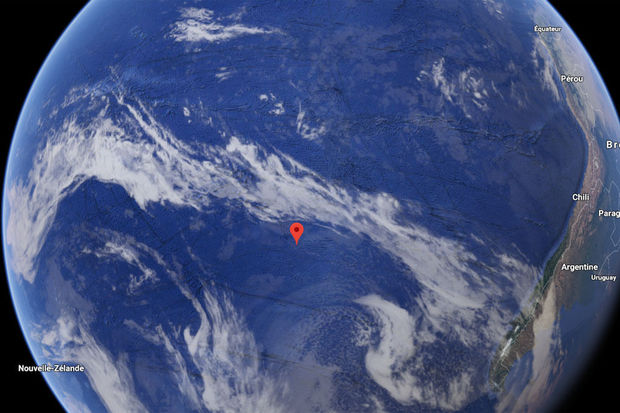

- Point NEMO

- Qui a construit la lune ?

- Révélations de Jean-Claude Bourret

- Stargate_Remote viewing

- Tablettes Mayas

- Trou noir galaxie

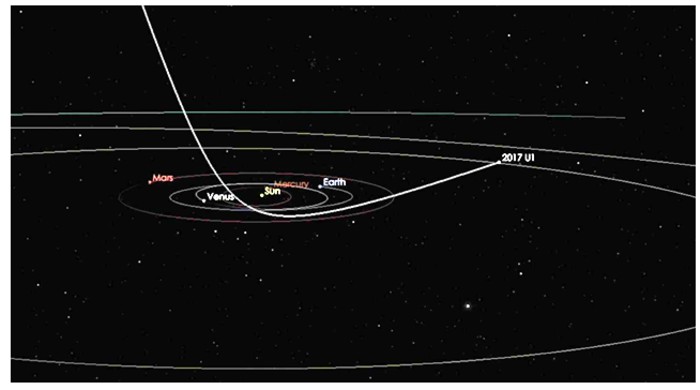

- Warp drive

-

Videos

Visiteurs depuis Avril 2005

Tech

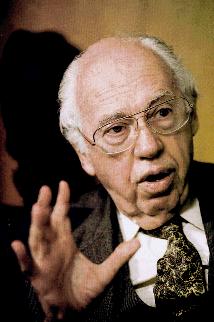

Par Jean Pierre PETIT ( site: https://www.jp-petit.org/)

Le problème de l'âge de l'univers.

Le problème de l'âge de l'univers.

...Bien sûr, nous essayons de lier logiquement ces différents travaux. Des arguments liés à la description de l'évolution de ces deux cosmos jumeaux nous amènent par exemple à la conclusion que la densité moyenne de ghost matter doit être supérieure à celle de la matière.

...Pour "traiter" le système des deux équations de champs couplées nous décrivons les deux feuillets d'univers par des métriques dites de Robertson Walker. Il s'agit de la métrique riemanienne qui intègre les deux hypothèses d'homogénéité et d'isotropie, donc c'est elle qui, dans le cas d'un seul univers, conduit aux solutions de Friedmann.

...Nous introduisons deux facteurs d'échelle R(t) et R*(t). Ce sont les dimensions caractéristiques liées à chacun des deux univers.

...Le problème concerne les conditions initiales. On suppose "qu'au tout début" (mais ce mot sera ultérieurement repris et commenté) les paramètres des deux univers sont identiques ( r = r* , p = p*). Dans ces conditions T = T* et les équations de champ deviennent :

La solution est alors :

Une expansion linéaire dans les deux univers.

...Objection immédiate : quid de la nucléosynthèse, de la synthèse de l'hélium, par exemple ? Une expansion linéaire serait beaucoup trop lente. Si on remonte le temps, comme dans le modèle standard on débouche sur des conditions où la température est suffisante pour correspondre à la fusion de l'hydrogène en hélium (et du ghost-hydrogen en ghost-helium).

...Dans le modèle standard, le modèle de Friedman c'est la rapidité de l'expansion, dans la phase primordiale, qui gèle la réaction et empêche que tout l'hydrogène soit converti en hélium.

...Réservons nous de répondre à cette question plus tard en disant simplement que le mode d'évolution est différent selon que la matière ou le rayonnement prédominent. Commençons par nous occuper de la "phase matière", lorsque la contribution du rayonnement devient négligeable (dans le modèle standard ceci correspond à t = 500.000 ans).

...On montre alors que ce mode d'expansion linéaire R = R* = ct est instable. Un des deux univers voit son expansion s'accélérer, alors qu'elle se ralentit dans le second. [Voir sur le site: Geometrical Physics A , 4 , 1998, section 2.]

...Nous supposons que c'est notre propre univers qui voit son expansion s'accélérer.

...Nous avons vu plus haut que la constante de Hubble était liée à la tangente à la courbe R(t). Dans le modèle standard, avec une constante cosmologique prise égale à zéro :

Avec ce nouveau modèle, nous avons :

...En ligne tireté la courbe qui correspondrait au modèle standard. On note, par rapport à celui-ci, un vieillissement de l'univers. En fait, dans cette instabilité des deux expansions conjointes, l'univers fantôme se comporte comme s'il propulsait en avant le nôtre, qui, en revanche, le freine.

...Le ghost universe se comporte.... comme une constante cosmologique. Son effet est semblable à ce mystérieux "pouvoir répulsif du vide".

...Il fut un temps où beaucoup de gens croyaient que le mercure montait dans les baromètres parce que la nature avait horreur du vide.

Aujourd'hui le vide n'est plus horrible : il est devenu repoussant

...Cette théorie des deux univers en interaction fournit une interprétation qui a l'avantage d'être moins ésotérique, personne ne sachant ce qu'est l'horreur du vide.

Ceci étant, l'univers qui a tendance à accélérer reste assez voisin de la loi linéaire, ce qui fait qu'on peut envisager un assez large éventail de scénarios d'expansion qui cadreraient avec ce problème de l'âge des plus vieilles étoiles de notre galaxie.

...Comment choisir entre tel ou tel scénario d'expansions conjointes R(t) et R*(t), liées à travers deux équations différentielles couplées ? [Voir sur le site: les équations (37-a) et (37-b) de Geometrical Physics A, 4, 1998.]

La structure à grande échelle de l'univers.

...Si le second univers voit son expansion contrariée par le nôtre, ralentie, sa densité r* s'y maintient à une valeur plus élevée, de même que sa température. On décide alors d'étudier l'instabilité gravitationnelle dans un système composé de deux populations, auto-attractives, mais qui se repoussent mutuellement.

...Selon la théorie, c'est la plus dense qui réagit le plus rapidement et de la manière la plus musclée. C'est elle qui donnera, par instabilité gravitationnelle, des conglomérats de ghost matter.

...Qu'est-ce que l'instabilité gravitationnelle, étudiée pour la première fois par Sir James Jeans, déjà cité.

...Considérons un milieu qui possède une densité r et dont les éléments sont animés d'une certaine vitesse d'agitation thermique Vth et proposons-nous d'étudier la croissance ou la dissipation d'éventuelles perturbations de densité. On suppose que, quelque part, s'est formée une surdensité d'un diamètre f .

...L'agitation thermique va tendre à dissiper naturellement cette perturbation. En combien de temps ? En un temps qui sera de l'ordre de

...C'est le temps que met un atome à parcourir la distance f, donc c'est aussi le temps que mettra ce grumeau a doubler son diamètre.

...Imaginons que la vitesse d'agitation soit nulle. Ces atomes s'attirent. Ce grumeau aura tendance à tomber sur lui-même. On sait calculer le temps mis pour qu'il se contracte. En fait, un "nuage de poussière" qui implose sur lui-même ressemble au Big Bang, à l'envers :

...On compare alors ces deux temps.

...Il y aura condensation d'une perturbation si le temps d'accrétion est inférieur au temps d'auto-dispersion, sous l'effet de l'agitation thermique.

...Les perturbation d'un diamètre supérieur à une longueur caractéristique, dite longueur de Jeans Lj , s'amplifieront et donneront des condensâts, des conglomérats de matière (clumps). .

...Lorsque ce "grumeau" de matière se forme, la matière se trouve comprimée, échauffée. Les forces de pression s'accroissent et finissent par stopper le processus.

...On appelle cela l'instabilité gravitationnelle ou instabilité de Jeans .

S'agissant du modèle standard, on pourrait se dire :

- Très bien. Après le Big Bang, l'univers, en expansion, va se refroidir, et la mise en œuvre de l'instabilité gravitationnelle va me permettre d'élaborer un scénario de naissance des galaxies et des étoiles.

...Si c'était si simple, ça serait déjà fait. En vérité on a aucun modèle de naissance de galaxie. Certains "croient" que les amas d'étoiles se sont d'abord formés, puis les galaxies, puis les étoiles. D'autres prônent l'opinion inverse.

...De plus tout ceci se déroule dans un univers en expansion encore intense. La détection de galaxies à très fort red shift montre qu'il s'agit d'objets très anciens (confirmé par l'âge des plus vieilles étoiles de la galaxie). On ne sait pas gérer tout cela théoriquement.

Mais on sait deux choses :

1 : Cette instabilité gravitationnelle ne peut jouer son rôle tant que le gaz de matière reste fortement lié au "gaz de photons", tant que l'univers reste ionisé. En effet les photons interagissent plus fortement avec les électrons libres (échappés des atomes) qu'avec les électrons orbitant autour des noyaux. Les photons, à leur façon, forment "un gaz". Lors de l'expansion celui-ci se décomprime, comme la matière et possède sa propre pression ou pression de radiation . Lorsque matière et photons sont fortement couplés, lorsqu'une masse de gaz ionisé tend à se contracter, elle entraîne ce gaz de photons avec elle.

- Mais les photons vont à la vitesse de la lumière ! Comment une masse de gaz de dimension finie peut-elle "emprisonner des photons" ?

...Emprisonner, s'entend. Dans cette masse de gaz les photons sont sans cesse absorbés et réémis. Au rythme de ces absoptions-rémission les photons ont beaucoup de mal à quitter cette masse gazeuse. C'est en ce sens qu'ils y sont retenus prisonniers (et c'est la même chose pour les photons émis au coeur du soleil, qui transitent très péniblement et très lentement vers sa surface).

...Quand l'univers est âgé de moins de 500.000 ans, non seulement le rayonnement se trouve piégé dans les masses de gaz ionisées qui auraient des vélléités de former des grumeaux, mais la pression de radiation est encore trop élevée pour autoriser ces condensations.

Conclusion : homogénéité de l'univers, ou quasi homogénéité jusqu'à t = 500.000 ans, selon le modèle standard. S'il se passe quelque chose, c'est après.

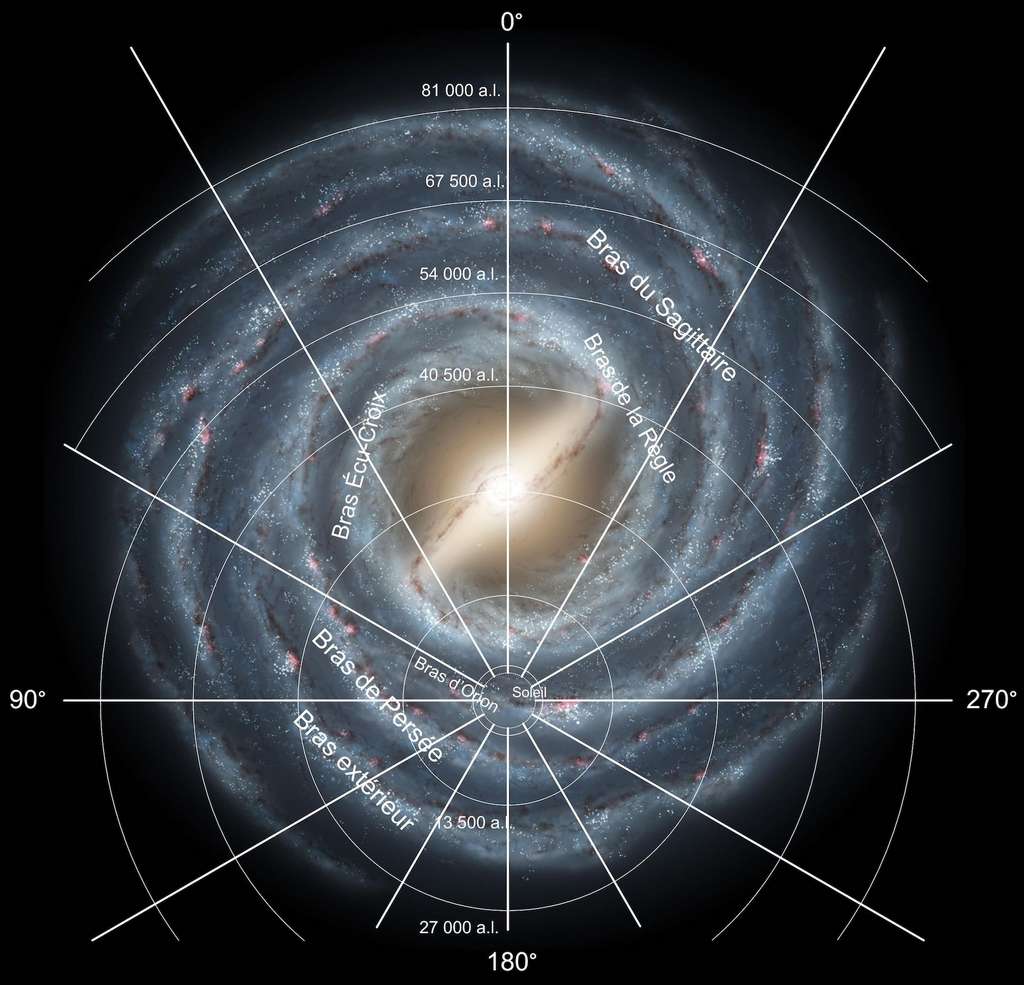

2 : Il existe des étoiles, rassemblées en galaxies, elles-même constituant une structure à grande échelle. Certains galaxies se rassemblent elles-mêmes en amas (amas Coma, amas Virgo) d'un millier d'individus. On avait cru au début que ceci se poursuivrait à une échelle supérieure et lancé l'idée d'existence de superamas, d'amas d'amas.

...L'observation a révélé quelque chose de totalement différent. En fait les galaxies se distribuent en formant ce qu'on pourrait appeler des "bulles de savon jointives". Les amas de galaxies ne sont que les "noeuds" d'une telle distribution. Ci-après, le résultat du dépouillement des observations (1977).

...Ainsi les galaxies se distribuent, à très grande échelle (Very Large Structure) autour de grandes bulles de vide dont le diamètre caractéristique est de l'ordre de la centaine de millions d'années-lumière.

...En suivant une autre approche, des chercheurs ont tenté de reconstituer de telles structure, en partant d'une distribution uniforme de matière (dans un seul univers, évidemment). La théorie initiale était celle de la croissance de perturbations planes, en crêpes (les "pancakes" de Zel'dovitch). Mais les résultats s'avérèrent décevant. Les simulations sur ordinateurs donnaient bien quelques cellules, mais celles-ci se dissipaient rapidement, par agitation thermique. Actuellement il n'existe pas de théorie convainquante de la formation de telles formations. Tout au plus parvient-on à assurer leur pérennité, toute relative, en les "consolidant" avec "de la matière sombre froide".

...Il existe une façon géométrique d'interpréter cette distribution de points-masses : matière ordinaire repoussée par des des conglomérats de matière fantôme, dessin qui a déjà été donné plus haut.

...On considère une surface qui correspondrait à une toile posée sur des piquets de tente, à l'extrémité émoussée. Notons au passage que plus l'extrémité de nos piquets seraient émoussée, plus le grumeau de matière fantomatique serait étendu. Situation opposée si ces piquets sont plus pointus. A la limite des piquets infiniment pointus correspondraient à des régions posicôniques : à des points de courbure positive concentrée.

...Donnons ici un autre modèle, qui va correspondre à la section suivante.

Instabilités gravitationnelles conjointes....C'est l'analogue de la théorie de Jeans, mais avec deux populations auto-attractives, qui se repoussent mutuellement. Voir : J.P.Petit and P.Midy : Matter ghost matter astrophysics. 4 : Joint gravitational instabilities.[Voir sur ce site: Geometrical Physics A , 7 , 1998.]

Lorsqu'un grumeau se forme dans l'un des feuillets, ce phénomène va de pair avec la naissance d'une bulle de vide dans l'autre.

Avec le modèle du jeu de dames :

Même schéma pour le matière fantôme "cernées" par des points de matière, invisibles pour elle) :

...Tout ceci à cause du fait que les photons émis par des particules de matière ne pourraient atteindre des particules de ghost matter, de même que des "ghost photons" émis par la ghost matter ne pourraient atteindre des particules de matière.

Il est facile d'imaginer la même situation en 3d, en faisant recours à un "damier tridimensionnel :

.Ci-après, un modèle didactique destiné à illustrer le phénomène des instabilités gravitationnelles conjointes. Imaginons une sorte de piscine. A mi hauteur, sous l'eau, on disposerait une toile, horizontale, souple, d'un poids négligeable. Au dessus on place des balles, dotées d'une certain poids, qui vont donc peser sur la toile. En dessus on dispose une quantité égale de balles de ping pong, de même volume. Celles-ci, sensibles à la poussée d'Archimède, vont aussi exercer une pression sur la toile, mais en sens inverse. On peut aussi s'arranger pour que toutes les billes soient de même diamètre.

.Ci-après, un modèle didactique destiné à illustrer le phénomène des instabilités gravitationnelles conjointes. Imaginons une sorte de piscine. A mi hauteur, sous l'eau, on disposerait une toile, horizontale, souple, d'un poids négligeable. Au dessus on place des balles, dotées d'une certain poids, qui vont donc peser sur la toile. En dessus on dispose une quantité égale de balles de ping pong, de même volume. Celles-ci, sensibles à la poussée d'Archimède, vont aussi exercer une pression sur la toile, mais en sens inverse. On peut aussi s'arranger pour que toutes les billes soient de même diamètre.

...S'il existe la même distribution, uniforme, de balles pesantes de de balles de ping-pong, de part et d'autre, la résultante des forces exercées sur la toile sera partout nulle et celle-ci restera horizontale (la courbure sera nulle). Mais le hasard peut faire que des balles pesantes se rassemblent, quelque part. Elles vont donc creuser la toile et, ce faisant, chasser les balles de ping pong plus loin. Schématiquement, en opérant une coupe, la surface prendra l'allure ci-après :

Des balles pesantes se rassemblent, et creusent la toile.

Elles chassent les balles de ping-pong, qui se rassemblent tout autour.

...Intuitivement, on imagine que les deux phénomènes, loin de s'opposer, ce conjuguent. La présence de cette anneau de balles en surnombre, autour de la cuvette, va accentuer son creusement, donc le "confinement" de ces balles denses.

...L'instabilité gravitationnelle pourrait être évoquée, avec une seule population, en disposant des balles pesantes sur un matelas de mousse suffisamment souple. Que quelques unes d'entre elles s'assemblent par hasard, quelque part, et elles vont créer une cuvette, une dépression, dans laquelle leurs voisines auront tendance à descendre. On appelle ceci un phénomène d'accrétion.

...Si on prenait une toile et que l'on dispose dessous, seulement, des balles de ping-pong, ce système-là serait aussi instable. Que des balles de ping pong se rassemblent en un endroit quelconque de la toile, elles vont inciter leurs voisines à les y rejoindre. Avec ce modèle à deux populations, les balles pesantes et les balles de ping pong, on a deux effets conjugués, qui évoque le phénomène d'instabilités gravitationnelles conjointes . Ce modèle a aussi l'avantage d'illustrer la symétrie qui existe entre les deux sous-systèmes.

...Si on reprend le système à deux populations, cela donnerait ceci :

Elles chassent les balles pesantes aux alentours.

On a donc cherché à tester cette idée en partant de deux distributions :

- Matière froide, densité r

- Ghost matter de densité r * @ 64 r , plus chaude : La vitesse moyenne d'agitation thermique dans le ghost universe V*th étant quatre fois plus élevée que dans le nôtre, paramètres issus de l'étude des expansions conjointes des deux univers, [voir sur le site: Geometrical Physics, 3, section 3 et figure 5 ].

...Les calculs ont été effectués à travers des simulations numériques 2d avec deux fois 5000 points-masses. Ils ne sont qu'indicatifs. Il faudrait effectuer des calculs en 3d et, pour ce faire, pouvoir gérer un nombre beaucoup plus important de points-masses, ce que notre système n'était pas capable de faire. Il ne faut donc pas prendre ces résultats 2d à la lettre.

...Qualitativement, la ghost matter mène le jeu. Elle donne naissance à des conglomérats, assez rapidement (son temps d'accrétion, inversement proportionnel à la racine carré de la densité est plus

court). Ces conglomérats (clumps) chassent alors notre propre matière dans l'espace résiduel en lui donnant ainsi sa configuration lacunaire. Voir : J.P.Petit, P.Midy and and F.Landsheat : Matter ghost matter astrophysics. 5 : Results of numerical 2d simulations. VLS. About a possible schema for galaxies' formation. [ Voir sur le site: Geometrical Physics A, 8 , 1998. ]

Les deux, superposés :

...L'intérêt est que cette distribution est alors stable. Les grumeaux de ghost matter stabilisent la distribution lacunaire matière et, inversement, celle-ci emprisonne ces grumeaux dans ses "mailles". Ceci expliquerait la grande stabilité obtenue (de l'ordre de l'âge de l'univers).Les 'mailles" de matière feraient alors office de barrière de potentiel vis à vis des éléments de ghost matter, issus des conglomérats et accélérés lors de collisions (au sens anglo-saxon de "encounter", c'est à dire interaction binaire entre deux points-masses de ghost matter).

Remarque (février 2000) :

Tous ces résultats de calcul datent de six ans. Comment on pu l'apprendre par ceux qui auraient lu mes livres, toutes ces simulations, fort intéressantes et prometteuses, ont été faites en 93-94, d'abord par mon collègue et ami Pierre Midy, sur "un vieux Cray", puis par "Fred", un jeune chercheur qui a préféré rester anonyme, ce en quoi je lui donne parfaitement raison. Les calculs avaient alors été effectués "en perruque" sur le puissant ordinateur gérant les données d'un accélérateur de particules Européen. Puis Fred avait changté de labo et dans sa nouvelle unité de telles choses n'étaient plus envisageables. L'approche simulation numérique fut donc abandonnée pendant six longues années. Mais tout récemment un fait nouveau est intervenu. Primo les machines ont fait de tels progrès en six années (vitesse et surtout capacité en mémoire vive) que des calculs qui n'étaient envisageables que sur de puissantes unités, affectées à la recherche, sont devenus à la portée de ... simples particuliers. Deux hommes, précisément des ingénieurs en retraite, mais passionnés d'astrophysique et de cosmologie, se sont donc manifestés. En programmant eux mêmes leurs machines ils avaient fait d'assez jolies simulations, en perturbant une "galaxie numérique 2d", constituée par 3000 points-masses par un "compagnon de passage", constitués par 300 points. Bref le schéma calssique conduisant à la forme spiralée de "la galaxie des chiens de chasse", alias M51. Quand on voit ces images on se dit tout de suite "cela correspond à ce qu'on savait faire il y a hui-dix ans dans les milieux recherche, avec de puissants moyens de calcul". Bien sûr, la structure spirale ne perdurait pas. Elle disparaissait quand le compagnon perturbateur s'éloignait (aspect que l'on connaissait de longue date). Nos deux ingénieurs, mis en appêtit par ces résultats encourageants, démarchèrent donc auprès de six astrophysiciens connus, en leur demandant "des directives", mais aucun d'eut la courtoisie de leur répondre. J'étais donc le septième astrophysicien qu'ils contactaient. Vous imaginez bien que j'ai été au contraire ravi de ce renfort et j'ai aussitôt branché ces nouveaux collaborateurs sur de nouvelles simulations. Apparemment ils s'en sortent fort bien et si tout se passe bien nous aurons "des résultats frais" dans les mois qui suivront". Attente passionnante, car le but n'est rien d'autre que de simuler la naissance d'une galaxie. Affaire à suivre.

La structure à grande échelle est issue du phénomène des instabilités gravitationnelles conjointes. Mais les densités r et r * sont fort différentes. On peut reprendre le modèle évoqué plus haut (les balles pesantes, dessus, et les balles de ping-pong, dessous. Il suffirait d'imaginer que les balles de ping-pong soient plus grosses et que les balles pesantes soient réduites à de simples plombs de chasse. On obtiendrait alors ceci :

Les balles de ping-pong se sont amassées en créant des bosses

et les plombs se sont distribués en étant repoussés dans les "vallées"

loin de ces promontoire.

...Notons au passage qu'on pourrait aussi envisager une situation inverse, où ce soient les balles de ping-pong qui adoptent une distribution quasi-uniforme, ce qui serait le cas si elles étaient suffisamment agitées, latéralement (milieu chaud). Sur le dessus de la matière ordinaire, plus froide, pourrait alors se rassembler dans une cuvette. On obtiendrait alors un modèle évoquant le confinement des galaxies, issu de leur environnement de matière fantomatique froide :

Modèle destiné à montrer comme la matière fantomatique (chaude)

participe au confinement de la matière ordinaire (froide).

...Un tel système devrait donner lieu à des "observables", non que ces grumeaux de ghost matter soient optiquement détectables : pour des raisons d'ordre géométrique ils ne le sont pas. Mais ils devraient modifier l'arrière-plan, par effet de lentille gravitationnelle.

...Nous avons vu qu'une concentration de matière M* (correspondant à des masses positives m*), située dans l'univers jumeau, dans le ghost universe, produisait, dans notre propre feuillet un effet de lentille gravitationnelle négatif (negative lensing).

Voir :

J.P.Petit : Twin Universe Cosmology : Astronomy and Space Science 226 : 273-307, 1995 and [sur ce site: Geometrical Physics A , 2, section 4.]

J.P.Petit and P.Midy : Repulsive dark matter. [ Sur ce site: Geometrical Physics A , 3, 1998, section 6.]

J.P.Petit and P.Midy : Matter ghost matter astrophysics. 2 : Conjugated steady state metrics. Exact solutions. [Sur ce site: Geometrical Physics A , 5 , 1998, section 4.]

...L'analogie avec une lentille de verre est relativement bonne. Une masse positive M fait converger les rayons. Une masse M* les fait diverger :

Analogie avec l'optique :

...Quand on observe du papier peint à pois à travers une lentille divergente, on peut apercevoir un plus grand nombre d'objets, de plus petit diamètre apparent. Mais c'est leur luminosité qui se trouve réduite (leur "magnitude apparente"):

...Cosmologiquement parlant, les conglomérats de ghost matter, faisant office de lentilles divergentes, devraient réduire la magnitude des galaxies à fort red shift, tout en multipliant leur nombre.

...Pour évaluer l'effet il faudrait connaître le diamètre des conglomérats de ghost matter, ce qui est difficile à faire. S'ils se forment, on ne sait pas a priori ce qu'ils peuvent devenir. Se constituent-ils en galaxies hypergéantes ?

...Si on les situe au centre des "grandes bulles vides" ils sont en moyenne à cent millions d'années lumière l'un de l'autre. Mais l'influence sur l'arrière plan lointain dépend fortement de leur diamètre f .

Voir :

J.P.Petit, P.Midy and and F.Landsheat : Matter ghost matter astrophysics. 5 : Results of numerical 2d simulations. VLS. About a possible schema for galaxies' formation. [Sur ce site: Geometrical Physics A, 8 , 1998., section 3, expression (23) et figure 18. ]

... Toujours est-il que si ces objets existent ils doivent créer l'apparence d'un grand nombre de galaxies naines, pour les forts red shifts. Or c'est précisément ce qu'on observe (P.J.E.Peebles : Principles of Physical Cosmology, Princeton Series in Physics, 1993)L'interprétation classique est que des galaxies naines se formeraient d'abord, puis donneraient naissance à des objets plus gros, par fusion, cannibalisme galactique (merging). Notre modèle offre une interprétation alternative de cet effet de nanisme des galaxies à fort red shift.

Vers une théorie de la naissance des galaxies.

...Il s'agit d'un scénario nouveau dont il convient d'en explorer toutes les implications. Toute la difficulté, non actuellement résolue, est de traiter tout en même temps. On ne peut pas dissocier le phénomène de l'expansion cosmique et la naissance des différentes structures. Pour le moment, on ne sait pas gérer les deux à la fois.

...Esquissons néanmoins un scénario hypothétique. Les grumeaux de ghost matter pourraient se constituer les premiers, en exerçant aussitôt une intense contre-pression sur la matière, qui s'échaufferait de ce fait. Voir papier cité ci-dessus [ Sur ce site: Geometrical Physics A, 8 , 1998, section 4, schémas 19, 20 et 21. ]

...En astrophysique, dès qu'un objet se condense, se rassemble, sa température s'accroît. Il en est ainsi par exemple pour les proto-étoiles. Ceci équivaut à une conversion d'énergie gravitationnelle (potentielle) en énergie cinétique (vitesse d'agitation thermique). La pression c'est la densité multipliée par la température (p = n k T). La pression s'accroît et contrarie l'effondrement. Une proto étoile, avant "allumage" est une masse sphéroidale de gaz à quelques milliers de degrés, de la taille du système solaire qui rayonne dans l'infra-rouge. Sous cette forme elle émet d'ailleurs plus d'énergie que plus tard, lorsqu'elle tirera celle-ci des réactions de fusion. C'est sa surface qui rayonne. Elle doit "transpirer" son énergie. Sans cela elle ne pourrait pas se contracter, accroître sa température à coeur et y démarrer le processus de fusion (minimum 700.000 degrés).

...La compacité de l'objet n'en fait pas un bon radiateur. A température égale, l'énergie thermique est comme le cube du rayon et la surface émissive comme le carré.

...Par contre la plaque constitue le radiateur optimal. Or en repoussant notre matière, les conglomérats de ghost matter la comprimeraient selon des plaques (les parois des "bulles de savon jointives"). Voir papier et figures cités ci-dessus.

...Les calculs seraient à faire, mais on peut supposer que cette géométrie se préterait à un refroidissement radiatif intense, donc à une déstabilisation du milieu vis à vis de l'instabilité gravitationnelle (pour ces problèmes d'instabilité gravitationnelle, voir ma bande dessinée Mille Milliards de Soleils, Ed. Belin, 8 rue Férou, Paris 75006, ou dans le "CD-Lanturlu").

...La matière tendrait alors à se fragmenter en proto-galaxies. Immédiatement, la ghost matter s'infiltrerait dans l'espace disponible et on déboucherait sur un schéma de galaxies logées dans des lacunes de matière fantomatique. Ceci donne le même schéma que celui issu de la présence de masses négatives dans notre univers (hypothèse de Souriau). Reprenons le schéma des galaxies environnées par de la "matière négative" (ghost matter, twin matter, matière à masse négative, peu importe le nom qu'on choisit de lui donner).

...Selon le schéma suggéré par Souriau, les masses négatives se repousseraient. Dans ces conditions elles ne fourniraient pas d'explication à la structure à très grande échelle de l'univers.

Une explication du confinement des galaxies.

...On obtient donc un schéma où de la matière fantomatique exercerait une contre pression sur la galaxie, assurant son confinement. C'est une alternative à l'idée de la présence de dark matter en son sein.

VoirJ.P.Petit and P.Midy : Repulsive dark matter. [Voir sur ce site: Geometrical Physics A , 3, 1998, section 2 ]. Mais il existe des galaxies sphéroïdales. Elles seraient donc logées dans des cavités de même géométrie, ménagées dans la distribution quasi uniforme de ghost matière environnante (rappelons nous qu'elle est plus chaude que la nôtre). Ces cavités seraient-elles alors confinantes ?

Ceci ne contredirait-il pas le théorème de Gauss ?

...Tous les étudiants en physique savent que si on charge uniformément une sphère, électriquement, le champ est nul à l'intérieur. On penserait alors à décomposer le champ gravitationnel créé à l'intérieur de la cavité sphérique en l'attribuant à des couches concentriques successives, chacune donnant une contribution nulle.

Cela paraît... évident. Mais ce théorème repose sur un pré-supposé : que la force de gravitation soit en 1/r2 à n'importe quelle distance, y compris.... à l'infini.

Un champ newtonien donne ce qu'on appelle l'équation de Poisson, par application du théorème de Green :

...L'équation de champ d'Einstein, à petite distance, pour des courbures faibles, en quasi-stationnaire (cosmologiquement parlant) et pour des vitesses faibles devant celle de la lumière, fournit la loi de Newton et l'équation de Poisson.

...Cette équation peut-elle gérer une distribution uniforme (r = Cte) et infinie de matière ? On l'a supposé jusqu'ici. Mais on débouche alors sur un paradoxe. Plaçons nous en symétrie sphérique, et en un point O quelconque, origine de nos coordonnées. L'équation de Poisson s'écrit alors :

où r est la distance radiale et Y est le potentiel gravitationnel, d'où dérive la force de gravitation g (radiale en symétrie sphérique) :

...L'équation n'admet pas de solution Y = Cte avec r différent de 0 . Il y a donc une force de gravité, ce qui semble paradoxal : On pourrait s'attendre à ce que chaque particule, subissant la force attractive de toutes ses voisines, subisse une force résultante nulle.

Cette solution est :

Le champ de gravitation, centré sur ce point O, est non nul et correspond à :

![]()

Non seulement ce champ n'est pas nul mais il tend vers l'infini avec r.

Une particule-témoin, immergée dans cette distribution, aurait donc tendance à tomber vers ce point O.

Dans le papier : J.P.Petit and P.Midy : Matter-ghost matter astrophysics. 7 : Confinment of spheroidal galaxies by surounding ghost matter. [ Sur ce site: Geometrical Physics A, 10 , 1998.] , on a réexaminé cette question du théorème de Gauss, de l'effet d'écran et de l'équation de Poisson. On montre que lorsqu'on considère une distribution uniforme de matière, éventuellement illimitée, l'équation de Poisson n'existe plus, tout simplement parce qu'il devient impossible de définir un potentiel gravitationnel dans un tel milieu. En effet la loi de Newton et l'équation de Poisson dérivent du formalisme de la Relativité Générale uniquement lorsqu'on peut disposer d'une solution à l'ordre zéro stationnaire , qu'on peut ensuite perturber. Or cette solution ne peut exister lorsque l'univers est non-vide. On obtient alors en Relativité Générale les solutions de Friedmann, fondamentalement instationnaires.

...Le champ à l'intérieur d'une cavité ménagée dans une distribution uniforme s'obtient alors simplement. Une distribution de ghost matter (qui se comporte comme un ensemble de masses négatives, par rapport à notre propre matière) comportant un lacune sphérique est équivalente à la superposition du champ créé par une distribution uniforme (nul), plus celui créé par une sphère emplie de matière ordinaire, de densité constante :

...Le champ créé par la sphère pleine croît avec la distance au centre, puis décroît. Une lacune sphérique est donc "confinante". Même chose pour une cavité ellipsoïdale. Si la frontière est abrupte, le champ de confinement serait équivalent à celui créé par un ellipsoïde aplati, empli de matière ordinaire avec une densité uniforme.

...Mais la frontière ne peut être abrupte. La lacune dans la ghost matter est floue et cette variation de densité s'accompagne d'un gradient de pression. C'est ce même gradient de pression qui inciterait la ghost matter à emplir la cavité si la galaxie disparaissait. Dans le papier [Geometrical Physics A , 2], section 2, des calculs ont été effectués avec des distributions de matière et de ghost matter plus sophistiqués. La méthode de calcul, analytique, a également été indiquée. On notera qu'on retrouve alors une courbe de rotation très semblable à celles qui sont issues des observations. Voir : J.P.Petit and P.Midy : Repulsive dark matter. [Sur ce site: Geometrical Physics A , 3, 1998. Figure 4. ]

...On a donc une théorie alternative à celle de la dark matter. Personnellement je pense qu'un modèle de galaxie, purement théorique, pourrait émerger de tout ceci, impliquant deux équations de Vlasov couplées, plus l'équation de Poisson. Voir, dans ce contexte : J.P.Petit : Twin Universe Cosmology : Astronomy and Space Science 226 : 273-307, 1995 and [ Sur ce site: Geometrical Physics A , 2, section 4. ]

où (r* > 0) se réfère à la densité de ghost matter. Le signe moins vient de la structure de l'équation de champ.

Negative lensing effect.

...La "preuve irréfutable" de présence de matière sombre dans les galaxies, selon les astrophysiciens, se fonde sur les forts effets de lentille gravitationnels observés. Les galaxie produisent des images multiples, de même que les amas de galaxies. Comme d'habitude, quand quelque chose appartient réellement au bestiaire cosmique, après un ou deux cas, ce sont des dizaines, puis des centaines d'observations qui déboulent. Effectivement les clichés s'accumulent.

...Les forts effets constatés ne cadrent pas avec les masses estimées des galaxies ou des amas de galaxies. Il y a un fort "effet de masse manquante". Mais un environnement inhomogène de ghost matter conduirait à des résultats identiques. Dans notre feuillet d'univers la ghost matter produit un effet de lentille gravitationnelle négatif.

... Dans le modèle, et dans notre feuillet d'espace-temps, des conglomérats de ghost matter (ou "matière gémellaire), présents dans la portions "adjacente" F* de notre feuillet F, créent une "courbure induite" négative dans celui-ci. C'est ce qu'on a tenté d'évoquer, didactiquement, plus haut, en utilisant lemodèle d'un "négacône émoussé", dont la partie centrale est en selle de cheval (une surface à densioté de courbure, négative, constante). Si on considère la figure ci-dessus, on a suggéré la présence d'un conglomérat de matière gémellaire, ou ghost matter, par un pointillé. Celui-ci n'est pas optiquement observable à partir de notre espace-temps (puisque, géométriquement, les photons ne peuvent pas passer d'un feuillet à l'autre). Par contre, comme suggéré sur la figure, ces conglomérats produisent un effet de lentille gravitationnelle négatif (negative lensing effect).Les trajectoires les photons, dans le feuillet F, sont schématiquement représentées. Mais ces photons ne peuvent interagir avec les atomes de ghost matter qui constituent le conglomérat présent dans la portion adjacente du feuillet F (dont le pourtour est représenté en pointillé). Ces photons "traversent donc librement le conglomérat".

...Comme on l'a déjà signalé, c'est le gradient de densité qui produit l'effet. Une distribution homogène de matière ou de ghost matter ne devierait pas les rayons lumineux.

...Tout se passe, pour la matière ordinaire "comme si la matière attirait les photons" et pour la ghost matter" comme si elle repoussait les photons". Une cavité ménagée dans la ghost matter aurait dont un effet focalisant, comme évoqué ci-après :

...L'indication n'est que schématique, mais, rassurez-vous : personne ne sait calculer le trajet d'un rayon lumineux dans une distribution inhomogène de matière (ou de ghost matter).

...A cette effet focalisant viendrait s'ajouter l'effet dû à la présence de la galaxie. En négligeant la présence de cet environnement de ghost matter autour de l'objet on ne saurait rendre compte du phénomène avec la masse seule de la galaxie (ou de l'amas de galaxies).

Une théorie alternative pour la structure spirale.

...Ce modèle fournit une nouvelle vision de la structure spirale, en l'imputant à l'interaction entre la galaxie et son environnement de ghost matter. La théorie de Françoise Combe se fonde sur l'interaction entre deux population: la matière de la galaxie et une masse d'hydrogène froid, indétectable et d'origine non précisée. A noter qu'un modèle d'interaction, à deux populations, avait déjà été suggéré en 1986 dans ma bande dessinée Mille Milliards de Soleils, Ed. Belin.

...Nous avons effectué des essais à travers des simulations 2d. Voir : J.P.Petit and F.Landsheat : Matter ghost matter astrophysics. 6 : Spiral structure. [ Sur ce site: Geometrical Physics A, 9 , 1998.]

...Inutile de doubler les images. Si faire se peut nous intégrerons sur le site l'animation, très suggestive, montrant la naissance d'une galaxie barré. On a deux régimes. D'abord une friction dynamique avec un fort ralentissement de la galaxie. La barre se forme très vite, de même que les bras spiraux. Le ralentissement devient alors insignifiant. Le système perdure alors pendant un grand nombre de tours, sa source étant l'effet de marée. Voir la suite des figures, dans l'article cité. Bien sûr, ces résultats doivent être accueillis avec circonspection, puisqu'il ne s'agit que de résultats 2d. Mais nos moyens de calcul ne nous permettent pas de faire du 3d. Si une équipe se proposait pour prendre le relais nous serions tout disposés à leur donner toutes les indications techniques nécessaires.

...Dans les simulations "classiques" le problème est d'assurer la survie des bras spiraux. Le phénomène correspond, de toute façon, à une dissipation d'énergie. Les éléments de la galaxie, les "étoiles", acquièrent donc des vitesses importantes, ce qui entraîne la disparition de la structure spirale, qui devrait donc être reconstituée par un nouvel apport de gaz froid, par exemple.

...Dans notre modèle il semble que l'environnement de ghost matter fasse office de "barrière de potentiel" et empêche ces objets de s'évader. La galaxie conserve alors ses bras spiraux pendant un grand nombre de tours. Mais ceci nécessiterait une confirmation en 3d.

...Comme évoqué plus haut, nous avons deux nouveaux collaborateurs au travail sur ces questions de simulation et nous espérons beaucoup de ces nouveaux travaux (la séquence montrant la naissance des bras spiraux dans une galaxie date de 1994...). La puissance de calcul des nouveaux matériels, accessibles à de simples particuliers, permet de "jouer dans la cour des grands" avec un simple micro. On peut même gérer assez de "points-masses" avec de tels systèmes qu'on pourra très vite représenter les galaxies telles qu'elles sont vraiment, c'est à dire avec deux "populations", fort différentes sous différents aspects :

- La "population I, ou population halo, constituée par des vieilles étoiles (et des amas globulaires), dont les trajectoires s'éloignent sensiblement du plan équatorial.

- La "population II" ou population disque, regroupant, dynamiquement, les jeunes étoiles et des masses de gaz d'importances variables. Ce second ensemble de masses se localise très près du plan équatorial de la galaxie. C'est dans cette population que se créer la structure spirale, en tant "qu'onde de densité". C'est alors un phénomène très non linéaire, qu'on peut même assimiler à une "onde de choc".

...Par contre le phénomène structure spirale affecte relativement peu la population I, qui concentre pourtant 90 % de lamasse de la galaxie. Il sera extrêmement intéressant de pouvoir enfin coller de plus près à la réalité astrophysique en représentant la galaxie, non à l'aide d'une unique population de points-masses, mais de deux.

La phase radiative.

Ici, nous revenons aux aspects cosmologiques du modèle. Comme évoqué plus haut, la solutions à départ linéaire (où R et R* au voisinage de t = 0, croissent proportionnellement au temps) pose problème. Une telle expansion serait beaucoup trop douce pour assurer le figeage de la nucléosynthèse primordiale. On a donc été amené à faire le lien avec des travaux antérieurs, datant de 1988-1989, intégrées au site:

J.P.Petit, Mod. Phys. Lett. A3 (1988) 1527

J.P.Petit, Mod. Phys. Lett. A3 (1988) 1733

J.P.Petit, Mod. Phys. Lett. A4 (1989) 2201

et avec :

J.P.Petit : Twin Universe Cosmology : Astronomy and Space Science 226 : 273-307, 1995 and [Voir sur le site: Geometrical Physics A , 2.]

...L'idée consiste alors à supposer que les constantes de la physique dépendent de la densité d'énergie. Dans les travaux antérieurs on avait montré que des variations conjointes des constantes de la physique pouvaient être envisagées, laissant invariantes toutes les équations de la physique (l'équation de champ, Schrödinger, Maxwell, etc...). Nous suggérons qu'un tel modèle puisse s'appliquer alors à la phase radiative, lorsque l'énergie-matière se trouve principalement sous forme de rayonnement.

...Lorsqu'on remonte vers le passé, la densité d'énergie-matière croît. On débouche, lorsque rr >> rm (lorsque la densité d'énergie-matière sous forme de rayonnement est grande devant la densité sous forme de matière) sur des lois :

...G étant la constante de gravité, m la masse, h la constante de Planck, c la vitesse de la lumière et e la charge électrique. On prend ces grandeurs égales dans les deux feuillets (sans justifier un tel choix).

...Avant de décrire ce modèle plus en détail, donnons-en la justification. On a vu plus haut que la remarquable homogénéité de l'univers primitif, traduite par celle du fond de rayonnement à 2,7°K, était difficilement justifiable dans un contexte standard. Il a donc fallu greffer sur l'ancienne théorie du Big Bang un nouveau modèle : l'inflation. Pour les français, ce mot est assez mal traduit. Il vient du verbe anglais to inflate, qui veut dire se gonfler. On est donc amené, au prix d'hypothèses lourdes, à supposer que l'univers aurait subi une fantastique expansion dans son "tout début". Alors son homogénéité peut être justifiée. Mais il est à noter que c'est la seule justification observationnelle du modèle de Linde, de cette théorie de l'inflation. Le prix à payer reste relativement élevé.

...Ici nous envisageons que les constantes de la physique puisse dépendre de la densité d'énergie matière, au delà d'un certain seuil. Ca n'est pas pire que les hypothèse qui sous-tendent la théorie de l'inflation, à tout prendre. Mais le profit est alors double :

- On justifie l'homogénéité de l'univers primitif

- On obtient une redéfinition de la variable temps.

...Pour l'homogénéité, c'est assez simple. On a vu que dans le modèle standard, à c constant, tout se joue en comparant l'horizon ct à la distance moyenne entre les particules.

...Dans cette nouvelle vision des choses, références [Sur ce site: Geometrical Physics A , 3, 1998, figure 17] et [Geometrical Physics A , 6 , 1998, figure 10,] en conservant cette variable chronologique t :

...L'homogénéité du milieu cosmique est donc assurée à toutes les époques. Cette différence tient au fait que la vitesse de la lumière c croît au fur et à mesure qu'on remonte vers le passé. Voir la figure 5 de la référence [Sur ce site: Geometrical Physics A , 6 , 1998].

Une remarque en passant :

...Pendant pas mal d'années, nous avons été "les olibrius qui s'amusaient à faire varier les constantes de la physique", thème de recherche qui n'avait absolument pas été pris au sérieux en France, en particulier dans les cénacles du CNRS. Beaucoup trouvaient l'idée parfaitement absurde "dans la mesure où les observations permettaient d'affirmer que ces constantes ne pouvaient pas avoir varié de manière sensible au fil des milliards d'années".

...On comprend une telle attitude, car il est vrai qu'aucune expérience ou observation n'a pu démontrer une telle variation d'un quelconque constante de la physique. Nous sommes bien d'accord. Mais en fait, la question est mal posée. Dans les travaux que nous avons développé depuis 1988 il a toujours été question de variations conjointes des constantes de la physique, des variations qui laissaient en particulier invariantes... les équations de la physique. Or tout expérience s'appuie sur de telles équations. Si les équations sont invariantes, alors le "phénomène" ne pourra pas être mis en évidence, simplement parce que les instruments de mesure "dérivent parallèlement au phénomène que l'on veut mettre en évidence".

...Donnons une image pour illustrer ce propos. Imaginez que vous mesuriez la longueur d'une table en fer avec une règle en fer. Vous trouvez une longueur constante. Est-ce à dire que la table garde une longueur constante ? Pas nécessairement. La température ambiante dans le laboratoire pourrait varier, phénomène que vous ne pourriez mettre en évidence à travers une dilatation de votre table en fer, simplement parce que votre instrument de mesure, votre règle de même métal, se dilate avec l'objet dont il est censé mesurer la longueur !

...Si rien n'est mesurable, me direz-vous, alors où est l'intérêt ? Comme montré dans nos travaux (y compris dans l'article publié avec Pierre Midy en août 1999 dans The International Journal of Physics D, intitulé "scale invariant cosmology" (cosmologie invariante par changement d'échelle, les observables sont de deux natures :

- Le redshift

- La prédiction de l'homogénéité de l'univers primitif.

...Venons-en au temps. Nous avons dit plus haut que le choix des coordonnées était arbitraire. Peut-on imaginer une mesure du temps qui soit invariante par changement des coordonnées ?

Nous l'avons sous les yeux. C'est le système solaire qui, lui, est parfaitement physique. Que nous la mesurions en nanosecondes ou en siècles, le nombre de révolutions de la Terre autour du soleil, par rapport à l'arrière-plan stellaire reste le même : c'est un nombre .

...Partant de ce constat nous allons donc imaginer une horloge conceptuelle constituée par deux masses orbitant autour de leur centre de gravité commun.

...Nous décidons que le nombre de tours effectué par ce système, par rapport aux autres objets qui l'environnent sera la définition du temps. Pas de temps sans horloge. Pas de temps sans phénomène de référence, quel qu'il soit. Sinon c'est un temps abstrait, un simple repère chronologique. Le temps c'est l'horloge. Des horloges qui accéléreraient ou ralentiraient au cours du temps, ça n'a pas de sens.

Lorsqu'on remonte vers le passé, nanti de cette horloge conceptuelle, la question à poser est :

- Combien de tours ce système a-t-il fait sur lui-même dans le passé ?

Dans notre modèle la réponse est : une infinité de tours.

...Si on retient donc ce compteur de tours comme horloge, le passé de l'univers devient infini. La singularité originelle est éliminée. On notera au passage que ce nombre de tours se trouve être

c'est à dire précisément ce temps conforme cher à Lévy-Leblond.

Autre remarque, dans ce modèle qui, dans sa phase radiative, devient "à constantes variables" cette quantité s'identifie également à l'entropie par baryon. Le cosmos devient non-isentropique. Le second principe revisité, en quelque sorte (le modèle standard nous offre une évolution isentropique).

...Cette vision du cosmos nous évite de nous demander "ce qui existait avant le Big Bang". L'adverbe avant devient de plus en plus vide de sens à mesure qu'on s'enfonce vers le passé.

...L'univers est une histoire qui se déroule "sous nos yeux". En quelque sorte, c'est un livre ouvert. Si vous allez voir un éditeur, pour publier un livre, il ne vous demandera quelle est l'épaisseur de votre manuscrit. En signant le contrat vous pourriez lui jouer un mauvais tour en lui soumettant un document dont les pages auraient une épaisseur variable. En ouvrant le livre à une page qui s'intitulerait "présent" et en le feuilletant à rebours, il pourrait découvrir avec désagrément qu'ayant utilisé des feuilles de plus en plus fines, vous lui présentez un livre qui contient un nombre de pages... infinies et qu'il n'aura jamais la moindre chance de lire votre préface pour savoir ce que vous avez voulu dire dans cet ouvrage.

Vous pourriez aussi utiliser des caractères de plus en plus petits, etc...

Un éditeur prudent, désireux de s'éviter un tel désagrément, demandera donc à l'auteur :

- Combien votre ouvrage comporte-t-il de caractères ?

Dans le cas de cet ouvrage "univers", la réponse, du moins en ce concerne le passé, serait : l'infini.

...En remontant dans le passé on compterait simplement une infinité d'événements microphysiques. Ceci constitue donc notre réponse à la question "des origines". Elle est bien différente des réponses que certains élaborent de nos jours. Voir à ce propos la déclaration faite par notre tout jeune académicien Thibaud-Damour à la revue Science et Vie, au rayon "Galerie de Portraits", à propos de sa théorie du "préBig-Bang", fondé sur une théorie qui en trente année n'a jamais été capable de fournir la moindre chose, tant au plan des observations que sur le terrain de l'expérience, j'ai nommé la TOE, la "théorie de tout", alias la "théorie des supercordes"

Mais le temps de Planck, dans tout cela ?...Celui-ci varie... comme t, c'est à dire qu'il maigrit au fur et à mesure qu'on s'enfonce dans le passé. La barrière de Planck s'éloigne comme un mirage. Quand à la longueur de Planck, elle varie comme R.

...Bien sûr, ce modèle ne gère pas "le reste de la physique". Pour le rendre complet il faudrait adjoindre des variations ad hoc des constantes liées aux autres interactions, forte, faible. Considérons que c'est une idée de plus, à débattre (ce qui est possible, nous le faisons de suite. Pour l'impossible, nous demandons un délai...)

...Le détail de ce modèle est à lire dans l'article [Sur ce site: Geometrical Physics A , 6 , 1998] . Pour mémoire nous donnerons les variations des constantes de la physique en fonction de la variable chronologique t .

Le temps dans le second univers.

...Dans ce qui précède nous sommes partis d'hypothèses purement géométriques, ce qui nous a amené à proposer un système de deux équations de champ, couplées. Nous avons vu que ce système était équivalent au fait d'inverser le signe des masses de la seconde population, bien que les masses m* soient positive.

...Quand on résout ces équations, on donne aux deux métriques des formes particulières, qui ne font que tenir compte de différentes hypothèses. On suppose que la Relativité Restreinte "fonctionne" dans les deux feuillets. Ceci nous amène à choisir une forme particulière de métrique Riemanienne, dite "à signature (+ - - -) ". Puis nous supposons que ces deux univers sont homogènes (que les paramètres, pression, densité, sont les mêmes en tout point de l'espace) et isotropes (que l'apparence de l'univers est la même quelle que soit la direction vers laquelle on se tourne. A l'aide de ces métriques particulières nous pouvons exprimer les tenseurs S et S* puis résoudre les équations, en obtenant en fin du compte des équations différentielles permettant de définir les évolutions de R et de R*, "facteurs d'échelle" des deux univers.

...On fait de même dans la théorie standard, sauf qu'on a une équation de champ unique, l'équation d'Einstein, une seule métrique et qu'on aboutit au bout du compte à une seule équation différentielle. C'est la célèbre équation de Friedmann :

Remarque immédiate : cette équation est invariante lorsqu'on change t en -t , elle est "time-reversible".

...En fait, rien dans notre physique ne nous permet de faire la différence entre le passé et l'avenir. Quoi qu'on fasse on est toujours ramené à une conception subjective du temps. Seuls nos sens nous permettent de faire la différence entre le passé et le futur.

...Une surface possède des géodésiques. Mais il n'y a pas de sens de lecture pour celles-ci. Le choix du sens du temps est arbitraire.

...Les équations différentielles couplées (équations (37-a) et (37-b) du papier [Geometrical Physics A , 6 , 1998] sont également invariantes quand on change t en - t.

...En remontant en amont, on sait qu'on peut repérer deux points conjugués M et M* de nos deux hypersurfaces avec le même jeu de coordonnées. Appelons ces coordonnées (t , z , x , h). On peut alors mener le calcul jusqu'au bout et obtenir les deux équations différentielles finales, couplées (écrivons-les) :

qui sont invariantes si je change t en - t .

A ce stade je peux très bien décider que : t = t t* = t

ou que : t = t t* = - t

...Les équations ne définissent aucune orientation temporelle a priori, pas plus que ne le faisait l'équation de Friedmann. Mais alors, que signifient ces variables t et t* ?

Ajout en date de février 2000 :

Entre le moment où j'avais composé ce texte et aujourdh'ui se sont situés tout un lot de travaux nouveaux concernant les trous noirs (ou plutôt allant dans le sens de leur inexistence). A la lueur de ces travaux, je dirais maintenant que les grandeurs t et t* ne sont que des coordonnées, et rien d'autre. Le fait qu'on décide par exemple que t* = -t ne signifiera absolument pas que si on passe du feuillet F au feuillet gémellaire F* on va se mettre à vivre "à rebrousse-temps". Dans ces nouveaux travaux ainsi évoqués on s'intéresse tout particulièrement à la manière dont les deux feuillets pourraient se trouver mis en communication (pendant un très bref instant, le temps d'un transfert hyperspatial de matière du feuillet F au feuillet F*). Qu'arrive-t-il alors à cette matière qui s'échappe vers "le versant rétrochrone de notre univers" ? Chemine-t-elle à contre-temps ?

...Elle évolue dans le feuillet F* où la coordonnée temps se trouve inversée. Mais en transitant d'un feuillet à l'autre, une masse témoin a suivi une géodésique. Sa "montre de bord" (c'est à dire son temps propre" continue de progresser vers le futur. Qui plus est cette particule témoin pourrait théoriquement réemerger dans F après avoir effectué un trajet en empruntant "les couloirs du gémellaire". Serait-ce à dire que cette pérticule témoin pourrait réemerger avant d'être partie?

...Non pas. A aucun moment son cheminement n'a été "rétrochrone". Mais alors, quelle est la nature ontologique de cette inversion du temps. Attention, il ne s'agit que de l'inversion de la coordonnée temps, pas du temps propre. En s'inspirant des travaux de Souriau (Structure des Systèmes Dynamiques, 1974, Dunod, page 198, équation 14.67) on sait qu'inversion de la coordonnée temps et inversion de la masse (et de l'énergie) sont des phénomènes conjoints. L'inversion du temps résulte de l'action des "composantes antichrones du groupe de Poincaré". Quand à l'inversion de la masse et de l'énergie elle découle de l'action du groupe sur son espace des moments.

...Ainsi "cheminer pendant un temps dans un feuillet où la coordonnée temps t* est inverse de la nôtre" signifie simplement que pendant ce temps où elle est "en plongée dans le jumeau" une masse témoin m contribue négativement au champ de gravité (relatif au particules restées dans son feuillet d'origine).

Iinverser le temps équivaut à inverser l'énergie et la masse.

Nous avons vu que nos particules de matière-fantôme se comportaient comme si elles possédaient une masse négative. On peut dire que si deux particules qui interagissent ont des masses positives, mais des flèches du temps inverses, elles se repoussent, gravitationnellement. Dans le papier : J.P.Petit and P.Midy : Geometrization of antimatter through coadjoint action of a group on its momentum space. 3 : Twin group. Matter anti-matter duality in the ghost space. Reinterpretation of the CPT theorem. [Sur le site: Geometrical Physics B, 3 , 1998.] nous avons tenté de dégager la structure de groupe qui sous-tendait cette géométrie gémellaire. Nous sommes arrivés à la conclusion que les deux feuillets étaient liés par des relations de symétrie et qu'en particulier leurs flèches du temps étaient opposées. On rejoint alors l'idée initiale d'André Sakharov et sa théorie des univers gémellaires.

- Détails

- Écrit par Gibé

- Catégorie : Tech

- Affichages : 3944

La MagnétoHydroDynamique est une méthode de propulsion encore considérée comme expérimentale, fondée sur les travaux de l'anglais Michael Faraday.

Jean-Pierre Petit, précurseur en france de la MHD a également exposé ses recherches sur le sujet à de nombreuses reprises dans ses livres et dans ses articles. Il commence à étudier dans les années 70 le principe de la propulsion par la MHD. Dès 1975 il publie une première note aux comptes rendus de l'Académie des Sciences de Paris, intitulée Convertisseurs MHD d'un genre nouveau, puis une deuxième note en 1976 avec Maurice Viton, présentant cette fois l'idée d'accélérateur MHD à champ magnétique alternatif.

Jean-Pierre Petit, précurseur en france de la MHD a également exposé ses recherches sur le sujet à de nombreuses reprises dans ses livres et dans ses articles. Il commence à étudier dans les années 70 le principe de la propulsion par la MHD. Dès 1975 il publie une première note aux comptes rendus de l'Académie des Sciences de Paris, intitulée Convertisseurs MHD d'un genre nouveau, puis une deuxième note en 1976 avec Maurice Viton, présentant cette fois l'idée d'accélérateur MHD à champ magnétique alternatif.

Vidéo temps X années 80....JPP+Bogdanoff..!

Vidéo temps X années 80....JPP+Bogdanoff..!

De la balle!

Site de Jean-Pierre Petit, astrophysicien:

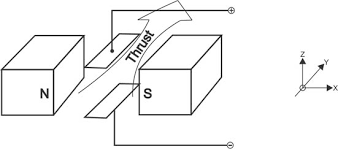

Le principe de la MHD, non envisageable dans le vide, consiste à faire circuler dans le milieu entourant le mobile un courant électrique. Le mobile, en même temps, va émettre un champ magnétique. Selon la loi de Laplace, ce champ va exercer une force sur le courant, et donc sur le milieu où il circule : c'est le principe de la plupart des moteurs électriques. Le milieu étant ainsi déplacé par rapport au mobile, c'est en fait celui-ci qui, par réaction, subira une force permettant de le propulser. Encore faut-il faire apparaître les champ et courant nécessaires :

pour le champ magnétique on y parvient facilement en installant dans ou sous les parois du mobile des bobinages (comme ceux des moteurs électriques) parcourus par un courant électrique approprié.

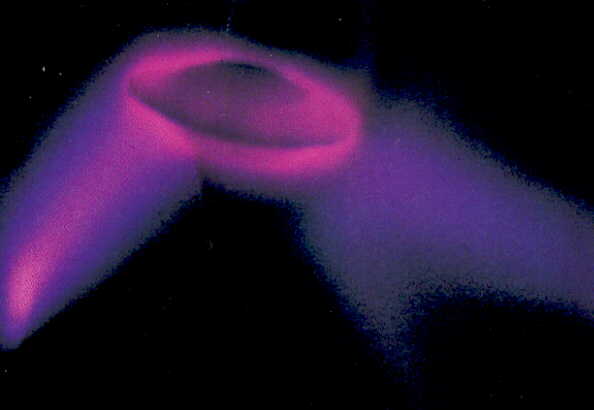

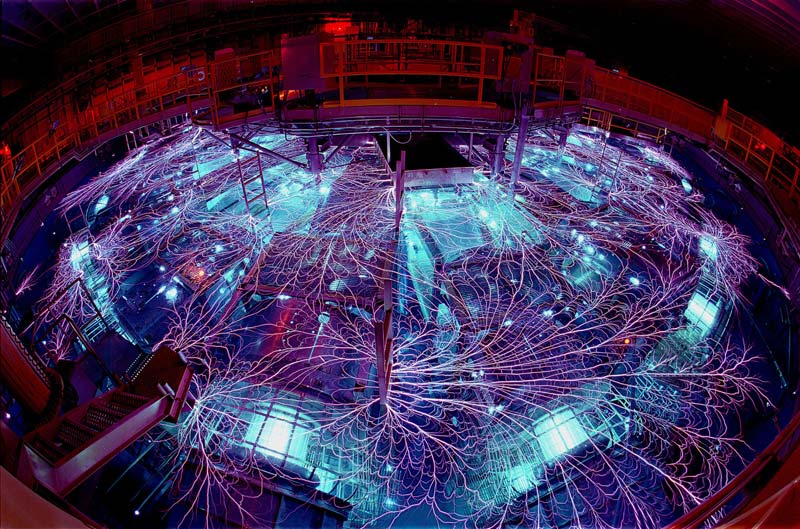

pour le courant électrique, tout dépend du milieu : dans l'eau de mer, il est facile de faire circuler un courant au moyen d'électrodes posées sur l'enveloppe du mobile. C'est pourquoi la propulsion MHD a été expérimentée, pour l'instant avec succès, aux États-Unis et au Japon, sur des maquettes de navires, aussi bien de surface que de sous-marins. Dans l'air, naturellement isolant, il est plus difficile de faire passer un courant électrique, mais on sait rendre l'air conducteur au moyen, par exemple, de champs électriques puissants engendrés, là encore, par des électrodes appropriées (l'air, rendu conducteur, peut devenir plus ou moins lumineux, ce que l'on a fréquemment observé autour des objets inconnus). Quant au champ magnétique, il peut être créé comme pour les bateaux. Cependant, dans l'air, la propulsion est beaucoup plus difficile à obtenir, puisqu'elle doit non seulement propulser le mobile, mais d'abord compenser son poids. Les champs électriques et magnétiques requis sont donc beaucoup plus intenses que pour un navire et, en pratique, il n'est guère envisageable d'obtenir les champs très intenses sans avoir recours à des bobinages supraconducteurs. Encore théoriques jusqu'à il y a quelques années, leur mise en oeuvre dans un véhicule aérien est, depuis 1991, une perspective crédible, avec la découverte de supraconducteurs capables de fonctionner à des températeurs proches de l'ambiante.

La propulsion dans l'atmosphère, sans hélices ou réacteurs, est donc en principe tout à fait possible par MHD, et le calcul montre que la puissance nécessaire n'est, dans certains cas, pas incompatible avec nos moteurs aéronautiques actuels 1 .

La propulsion dans l'atmosphère, sans hélices ou réacteurs, est donc en principe tout à fait possible par MHD, et le calcul montre que la puissance nécessaire n'est, dans certains cas, pas incompatible avec nos moteurs aéronautiques actuels 1 .

Les premiers travaux sur la propulsion MHD, avec ionisation d'un gaz, datent de l'immédiat après-guerre et ont sans doute été envisagés sommairement avant 1939 2 3 .

Kulsrud (1958)

Donald Menzel en 1962, traitant de MHD Donald Menzel en 1962, traitant de MHD.

Dans un rapport à l'American Rocket Society, le physicien de l'Université de Princeton Dr. Russell M. Kulsrud a indiqué que le nouveau domaine de l'"hydromagnétique" (anciennement appelée magnétohydrodynamique) pourrait aider à résoudre le problème de la réentrée de missile 5 . Dans les dispositifs de fusion nucléaire (bombes H par exemple) les champs magnétiques sont utilisés pour maintenir les gaz électrifiés à distance des murs d'un conteneur suffisamment long pour que la réaction nucléaire puisse avoir lieu. Le même principe, dit-il, pourrait être utilisé pour détourner les gaz chaud générés par les appareils plongeant dans l'atmosphère. Le docteur Kulsrud, qui travaille sur le projet Matterhorn de physique des plasma à Princeton, a également dit que le concept de science-fiction de l'utilisation de "champs de force" pour repousser les objets arrivants devenait une réalité en hydromagnétique.

Le premier brevet sur la propulsion MHD en milieu marin date de 1961, déposé par l'américain Rice. En 1962, un 1er rapport sur le sujet est rédigé par un autre américain, du nom de Phillips.

Way

Un autre rapport est signé du Dr. S. Way, consultant pour les laboratoires de recherche de Westinghouse à Pittsburgh, publiée en 1964 par une importante association technique américaine, l'American Society of Mechanical Engineers (ASME) 6 . L'étude de Way a pour titre Propulsion de sous-marins par les forces de Lorentz dans un environnement marin et est présentée à la réunion annuelle de l'ASME du dimanche 29 novembre au vendredi 4 décembre. Ce texte de 8 pages décrit le schéma de principe de la MHD marine, avec formules mathématiques et tableaux chiffrés. Way y fait référence aux études antérieures de Rice, Friauf, Phillips et Bryson, ainsi qu'à un papier récent du lieutenant Doragh qui, selon lui, renouvele la question.

En 1966, Way teste avec succès sa théorie avec un sous-marin en modèle réduit de 3 m de long et de 400 kg, dans la baie de Santa Barbara (Californie).

Le lundi 22 janvier 1968, un article de Aviation Week & Space Technology indique comme Northrop compte remédier au problème du bang sonique grâce à la MHD.

Friedman

Viennent ensuite des textes du physicien nucléaire et ufologue Stanton T. Friedman dans lesquels il évoque la propulsion MHD dans le milieu aérien : d'abord un article de février dans la revue Astronautics and Aeronautics (revue de l'AIAA), où il écrit :

Une étude de la littérature et une extrapolation de la technologie existante suggèrent que, moyennant un effort considérable, une approche EM entièrement nouvelle pourrait être développée pour le vol hypersonique qui, par bien des aspects, dupliquerait les caractéristiques des ovnis.

Puis sa déclaration au Symposium sur les ovnis en juillet. Il y parle du sous-marin de Way et qu'il suffirait d'extrapoler la théorie de la MHD sous-marine développée dès 1964 par Way dans l'atmosphère (parlant alors de "magnétoaérodynamique") pour ouvrir une nouvelle piste quand au mode de propulsion des ovnis. A la question : "Se pourrait-il qu'ils soient liés à un moyen de propulsion ?" Il répond : "Il y a un nombre considérable de travaux disponibles concernant la magnétoaérodynamique. J'ai reçu une bibliographie de la NASA avec plus de 3000 références. La référence 39 contient le résumé de plus de 300 publications traitant des interactions entre véhicules et plasmas. Une bonne partie de ce travail est secrète car le nez des ICBM est entouré de plasma. En tous cas, il y a un corpus technologique que j'ai étudié et qui me conduit à croire qu'une approche entièrement nouvelle pour la propulsion à grande vitesse dans l'air et dans l'espace pourrait être développée, en utilisant les interactions entre les champs électriques et magnétiques avec des fluides conducteurs adjacents aux véhicules pour produire une poussée ou une sustentation (poussée ou soulèvement), et réduire ou éliminer d'autres problèmes de vol hypersonique tels que la traînée (drag), le bang sonique, l'échauffement, etc. Ces notions sont basées sur la technologie existante, telle que celle figurant dans les références connues, bien que l'on puisse s'attendre à ce qu'un effort considérable de développement soit nécessaire."

Meessen

Les premières publications de Auguste Meessen sur la propulsion MHD datent de 1973, dans les numéros 8, 9 et 10 de la revue Inforespace de la SOBEPS. Dans le n° 10, Meessen fait état des travaux de Way et Friedman :

Nous avons appris entre-temps que le physicien américain S. T. Friedman admet également que la physique des plasmas pourrait intervenir dans la propulsion de ce qu'il appelle des "modules d'excursion terrestre". Il suppose (comme dans notre premier modèle) qu'un champ magnétique exerce une "force de Lorentz" sur des courants ioniques et il rappelle également l'existence du sous-marin électromagnétique expérimental de Way.

Ces premières études du professeur Meessen sont également mentionnées dans le livre de Michel Bougard, Des soucoupes volantes aux Ovnis, paru en 1976 en Belgique. On sait qu'il a continué à développer ses idées sur la propulsion MHD, dont on peut se faire une idée dans le livre récent de Jacques Dumont, OVNIS : Un 1/2 siècle de recherches.

Les études de propulsion marine sont apparemment laissées de côté jusqu'à la fin des années 1970s car on ne sait pas encore fabriquer les bobines nécessaires à la production des importants champs magnétiques réclamés par la MHD 9 . En l'occurrence, le sous-marin en modèle réduit de Way se déplaçait très lentement, comme on peut le voir sur une vidéo produite par Friedman. C'était d'ailleurs un modèle simplifié qui ne comporte que deux électrodes .

Ummites ?

Se pose ici la question de l'antériorité de la lettre ummite par rapport aux études déjà publiées. Nous trouvons la lettre en question dans le livre d'Antonio Ribera, 11 12 . Selon Ribera, cette lettre de 43 pages, évoquant brièvement la MHD, fut reçue par l'ingénieur en bâtiment Enrique Villagrasa le mardi 9 janvier 1968. Selon d'autres sources, elle a été reçue le dimanche 9 juin et non pas le 9 janvier. Si c'est exact, le 1er article de Friedman, paru en février, lui est antérieur.

Progrès publics

En avril 1991, la revue Science & vie fait sa une sur le "sous-marin MHD". Suit un article qui évoque les percées récemment réalisée dans ce domaine : les navires de surface et les sous-marins vont connaître bientôt une véritable révolution, grâce à la propulsion électromagnétique, découlant des progrès récents en matière de supraconduction. On y parle d'un projet japonais de brise-glace sans hélices, propulsé par la MHD. Ce projet s'appuyait sur les résultats d'essais d'une maquette de 3,6 m de long pesant 700 kg, réalisée en 1979 par l'université de la marine marchande de Kobé, et qui tenait compte d'une maquette précédente, réalisée en 1976 13 . L'article comporte une photo d'une vedette construite par les japonais, prête pour les essais, équipée de 2 propulseurs MHD, identiques à celle que Jean-Pierre Petit a fait naviguer 10 ans plus tôt dans un petit bassin d'eau salée sur le plateau de l'émission Temps X de TF1. Une illustration décrit l'accélérateur pariétal que Petit à expérimenté en 1975, sans le mentionner.

Ce sont les progrès réalisés dans le domaine des matériaux supraconducteurs qui ont permis de reprendre dans de meilleures conditions ces études de propulsion marine par la MHD. Les japonais, en pointe dans ce domaine, ont pu construire une vedette de 185 t et longue de 30 m environ, le Yamato 1, qui a navigué avec succès le vendredi 19 juin 1992 dans la baie de Kobé. Les américains, eux, sont sans doute les plus avancés, les plus innovants, dans ce domaine grâce aux travaux qu'ils mènent notamment au Naval Underwater System Center de Newport et au Laboratoire d'Argonne. On suppose d'autre part que les russes ne sont pas restés les bras croisés dans ce domaine. En France, la recherche s'est organisée également, au laboratoire de Grenoble déjà nommé, avec le concours de la société Jeumont-Schneider Industrie, et avec la collaboration de 4 laboratoires de l'INP associés au CNRS 15 .

- Détails

- Écrit par Gibé

- Catégorie : Tech

- Affichages : 4001

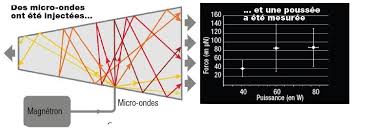

La NASA a réalisé une expérience qui pourrait bien chambouler les voyages spatiaux des prochaines décennies. Les résultats de cette expérience, publiés il y a quelques jours seulement, tendent à montrer qu’une propulsion spatiale jugée impossible par de nombreux scientifiques, est en fait… possible. Et franchement, sur ce coup, la NASA a bien perdu plus de 10 ans en refusant de prendre au sérieux le scientifique qui avait imaginé ce design en 2004.

Il y a 10 ans, Roger Shawyer, un scientifique britannique, a imaginé l’emDrive, un système de propulsion qui utilise une technologie micro-onde brevetée pour convertir l’énergie électrique en poussée. Le plus dingue avec ce dispositif, c’est qu’aucun combustible n’est nécessaire. Il suffit juste d’un peu d’électricité pour faire fonctionner ce moteur.

Il y a 10 ans, Roger Shawyer, un scientifique britannique, a imaginé l’emDrive, un système de propulsion qui utilise une technologie micro-onde brevetée pour convertir l’énergie électrique en poussée. Le plus dingue avec ce dispositif, c’est qu’aucun combustible n’est nécessaire. Il suffit juste d’un peu d’électricité pour faire fonctionner ce moteur.

Sauf que pendant 10 ans, Roger Shawyer a tenté en vain de faire valider son système de propulsion par la communauté scientifique. Ce type de moteur électromagnétique est contraire à la loi de conservation de la quantité de mouvement.

Sur son site, il explique qu’en 2007, des scientifiques chinois se sont intéressés à son système de propulsion. Ils ont donc construit un propulseur similaire mais distinct et ils ont pu mesurer une poussée de 85 mN (millinewton), autant dire pas grand-chose, mais c’est suffisant pour accélérer un satellite de manière constante. De plus, comme il n’y a pas besoin d’embarquer de carburant, l’engin est plus léger, donc moins cher à envoyer dans l’espace. Et surtout, une fois équipée de panneaux solaires, le satellite est manœuvrable pour une durée incroyablement rallongée.

Quand les résultats de l’expérience chinoise ont été publiés en 2011, Sawyer a retrouvé un peu d’espoir. Surtout que d’autres tests ont été réalisés par un scientifique américain qui encore une fois a utilisé un design distinct mais similaire.

Agacée par ces résultats qu’elle refusait d’admettre, l’Agence spatiale américaine a enfin accepté de mener ses propres essais avec un nouveau système de propulsion distinct mais similaire à l’emDrive. L’agence a donc réuni 5 scientifiques qui ont ainsi pu montrer qu’il était possible d’obtenir une poussée stable entre 30 et 50 mN.

Pour Shawyer, le créateur de ce moteur, c’est une belle victoire et on devrait entendre parler de lui dans les prochaines mois ou années. Son design permet une poussée de 96 mN, ce qui est bien supérieur aux résultats obtenus par les Chinois ou la NASA. Pour lui, le plus important, c’est d’obtenir enfin une reconnaissance scientifique.

Shawyer a déjà un nouveau design dans ses cartons. Son système de propulsion modifié pourrait selon lui être utilisable sur Terre, pour propulser les voitures et pourquoi pas, un jour, les avions.

- Détails

- Écrit par Gibé

- Catégorie : Tech

- Affichages : 4506

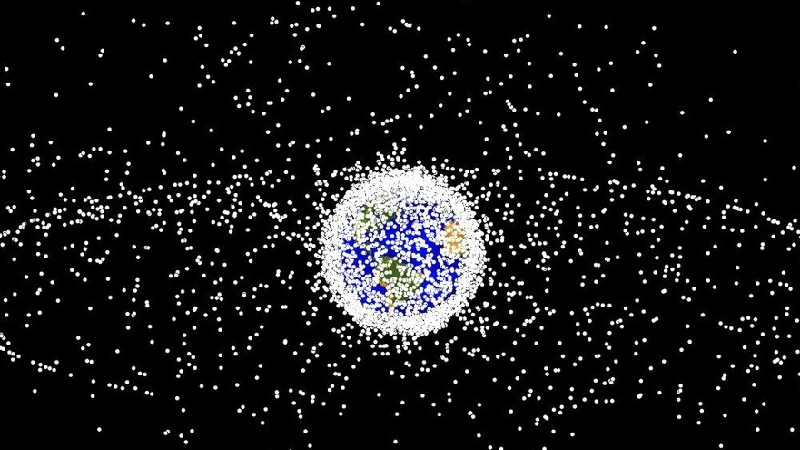

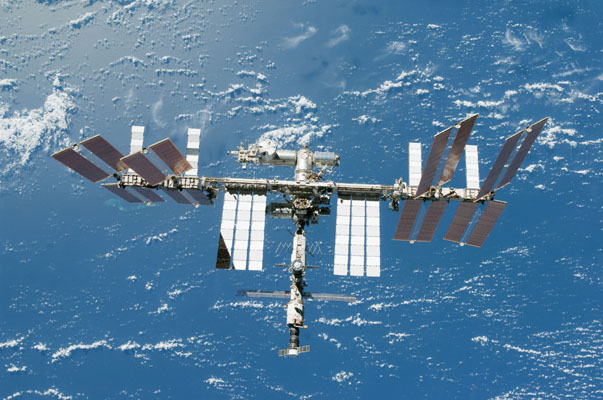

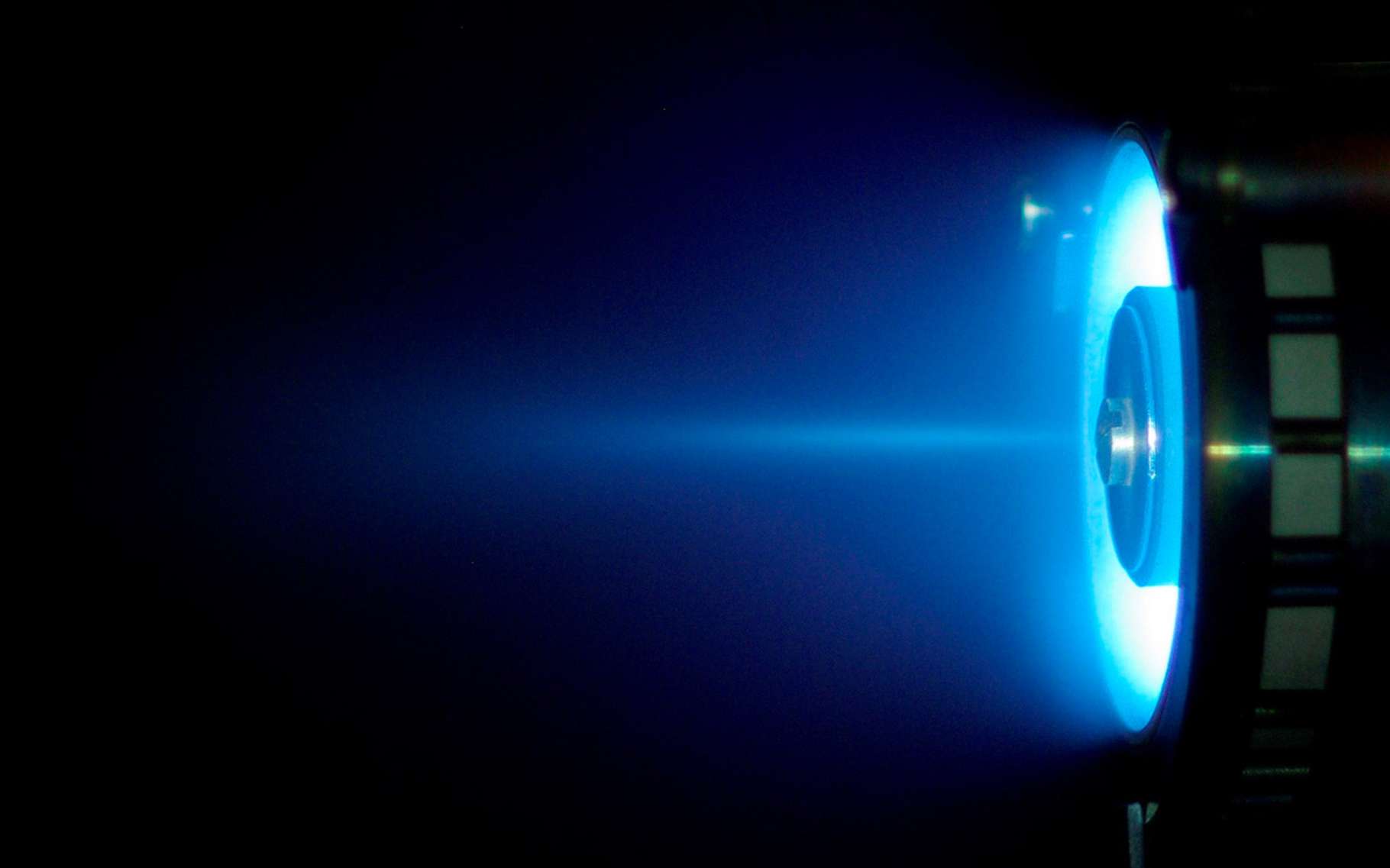

La propulsion électrique, qui pour la première fois a pris le pas sur la traditionnelle propulsion chimique à bord de satellites militaires dans les années 2000, est pressentie par certains comme une technologie de rupture pour l’alimentation des systèmes orbitaux nouvelle génération. Surtout depuis l’année 2012, où Boeing avait déferlé la chronique en annonçant avoir reçu pour la première fois des commandes pour des satellites commerciaux électriques. Qu’en est-il réellement ? Découverte de ces engins volants tout électriques et analyse de leurs véritables intérêts.

La plateforme 702SP de Boeing est équipée de propulseurs électriques et a déjà fait l’objet de plusieurs commandes (source Boeing).

Le gain de poids comme principal atout

Pour propulser un satellite sur son orbite finale et effectuer des corrections de trajectoire, la norme est de faire appel à un système de propulsion chimique. En nécessitant d’embarquer des substances nécessaires à la réaction chimique comme les ergols liquides, cette technique mobilise une part importante de la capacité d’emport des satellites. Si le choix est fait d’équiper un satellite de propulseur électrique, un fabricant peut gagner jusqu’à dix fois la masse équivalente d’un ensemble de propulsion chimique.

Malgré un intérêt indéniable sur le plan de la masse d’emport, les moteurs à impulsion électriques ne brillent pas pour leurs performances : quand un propulseur chimique peut fournir jusqu’à plusieurs milliers de Newton de poussée, les meilleurs propulseurs électriques ne peuvent générer une poussée supérieure à 200 Newtons. C’est d’ailleurs pour cela que ce système de propulsion est aujourd’hui adapté uniquement aux petits satellites pour l’observation terrestre (circulant donc en orbite basse).

Les orbites géostationnaires correspondent sur cette image aux orbites les plus éloignées de la Terre. Leur altitude est de l’ordre de 35 000 km (source satellitetoday.com).

Une faible poussée mais des domaines d’utilisation intéressants

Alors comment des propulseurs de très faible poussée peuvent-ils être utiles à bord des satellites ? Les domaines d’utilisation ne manquent pas. Par exemple, une des principales missions à la portée des propulseurs électriques réside dans les circularisations d’orbite. Cette manœuvre orbitale qui consiste à stabiliser un satellite sur une orbite circulaire à partir d’une orbite elliptique est très couramment utilisée pour les missions géostationnaires. Les opérateurs de satellites affirment par ailleurs que la propulsion électrique pourrait se révéler idéale pour contrer les effets de l’atmosphère résiduelle pour les satellites en orbite basse. La mission franco-israélienne Venµs, dont le lancement s’est tenu en août 2017, permettra de tester l’efficacité des moteurs électriques pour compenser cette trainée résiduelle.

Mais Le principal atout de la propulsion électrique réside surtout dans la durée de vie des satellites qui en sont équipés. Les propulseurs chimiques, limités par la charge d’ergol emportée ne permettent pas aujourd’hui de réaliser des missions supérieures à 15 ans. En équipant un satellite de moteurs électriques rechargés grâce à des panneaux solaires, les durées de vie dépassent aisément les valeurs usuelles. Un atout qui fait de la technologie électrique un moyen de propulsion apprécié par les financeurs de missions orbitales, dont le plan d’affaires se trouve amélioré.

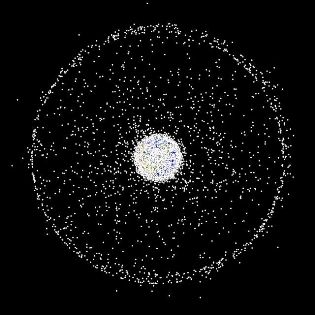

Recherche et avenir du satellite électrique

Les satellites électriques n’ont malheureusement pas que des atouts. Entre un coût d’achat élevé et l’impossibilité de réaliser des manœuvres rapides pour des transferts orbitaux ou des évitements de débris, les engins spatiaux équipés de la technologie n’ont pas que des adeptes. Depuis la fin des années 2010 toutefois, la recherche en faveur des propulseurs électriques s’est accélérée. L’objectif pour les laboratoires de recherche est avant tout de développer un moyen de rendre la production en série de ces moteurs viable. Plus ceux-ci seront miniaturisés et puissants, plus leur attractivité sur le marché des nanosatellites et des microsatellites sera marquée. C’est notamment l’objectif du laboratoire Icare du Centre National de Recherche Spatiale, qui se penche sur des moteurs à propulsion plasmique d’une poussée comprise en 1 et 10 millinewtons.

Lors de la 31e conférence consacrée aux télécommunications par satellites qui s’était tenue à Washington en 2012, Boeing avait annoncé avoir reçu la commande pour quatre satellites électriques. Depuis, ce ne sont pas moins de 18 autres satellites électriques qui ont été commandés auprès de différentes compagnies. Preuve qu’un engouement pour la technologie et les gains de poids qu’elle permet existe bel et bien. Le premier CubSat (nanosatellite cubique) à être équipé de propulseurs électriques, Aoba Velox 3, a été lancé en décembre 2016. Son opération permettra d’en savoir un peu plus sur la vie orbitale d’un tel système.

Outre l’engouement suscité par la technologie de propulsion électrique, certains opérateurs gardent à l’esprit que, d’un point de vue production en série, rien n’est jouer pour ce type de propulseur. Toutefois, la nouvelle génération de nanosatellites et microsatellites commerciaux qui devrait emplir les cieux dans les prochaines années seront assurément impactés par la tendance du tout électrique. Nous entrons à n’en pas douter dans l’ère du satellite électrique. Reste à savoir si demain, même les plus gros d’entre eux pourront bénéficier des avantages de la technologie.

- Détails

- Écrit par Gibé

- Catégorie : Tech

- Affichages : 3643